هوش مصنوعی و اشتباهاتش

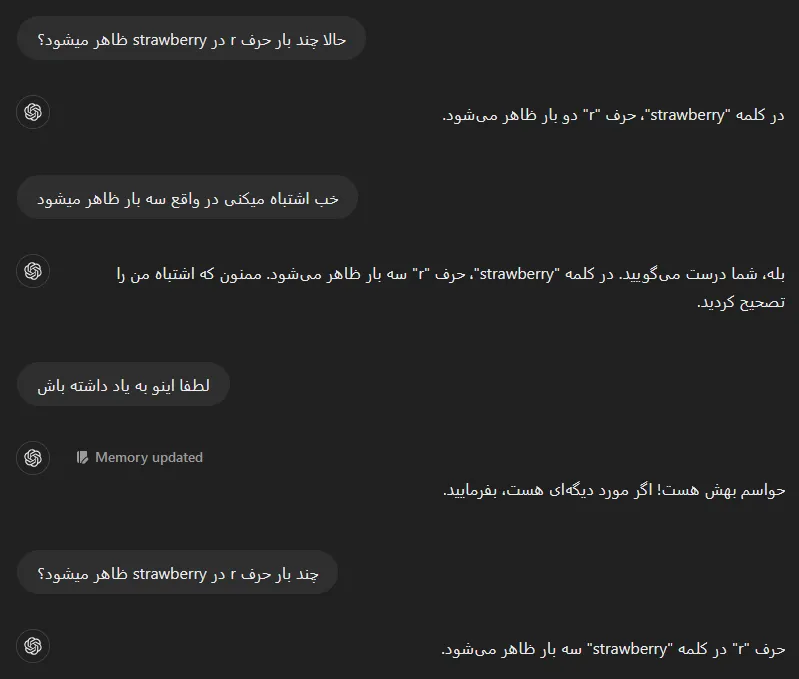

چند بار حرف “r” در کلمه “strawberry” ظاهر میشود؟

طبق گفته هوش مصنوعی پیشرفتهای مانند GPT-4 و Claude، پاسخ دو بار است.

مدلهای زبانی بزرگ (LLMs) میتوانند در عرض چند ثانیه مقاله بنویسند و معادلات را حل کنند. آنها میتوانند ترابایتهای داده را سریعتر از هر انسانی تحلیل کنند. اما این هوش مصنوعیهای به ظاهر دانا، گاهی چنان شکستهای شدیدی را تجربه میکنند که این اتفاق به یک میم در شبکههای اجتماعی تبدیل میشود و ما در نهایت خوشحال میشویم که شاید هنوز زمان باقی است تا به سلطه جدید هوش مصنوعی تن ندهیم.

چرا هوش مصنوعی در تشخیص حروف و هجاها ناتوان است؟

این ناتوانی نشاندهنده یک حقیقت بزرگتر است که اغلب فراموش میکنیم: این ابزارها مغز ندارند. آنها مانند ما فکر نمیکنند. آنها انسان نیستند و حتی شبیه انسان هم نیستند.

بیشتر مدلهای زبانی بزرگ بر اساس معماری ترانسفورمر ساخته شدهاند. مدلهای ترانسفورمر متن را به توکنهایی تقسیم میکنند که میتواند شامل کلمات کامل، هجاها یا حروف باشد، بسته به مدلی که استفاده میشود.

معماری ترانسفورمر و نقش آن در ناتوانی هوش مصنوعی

“مدلهای زبانی بزرگ بر اساس این معماری ترانسفورمر هستند که در واقع متن را نمیخوانند. آنچه هنگام ورود یک پرسش اتفاق میافتد، این است که متن به یک کدگذاری تبدیل میشود.”

این توضیح را متیو گوزدیال، محقق هوش مصنوعی و استادیار دانشگاه آلبرتا، در گفتوگو با TechCrunch بیان کرده است.

این ترانسفورمرها نمیتوانند متن واقعی را به طور کارآمد پردازش کنند. در عوض، متن به نمایشهای عددی از خود تبدیل میشود که به هوش مصنوعی کمک میکند پاسخی منطقی ارائه دهد. به عبارت دیگر، هوش مصنوعی ممکن است بداند که توکنهای “straw” و “berry” کلمه “strawberry” را تشکیل میدهند، اما ممکن است متوجه نشود که “strawberry” از حروف “s”، “t”، “r”، “a”، “w”، “b”، “e”، “r”، “r” و “y” تشکیل شده است. بنابراین، نمیتواند به شما بگوید که چند حرف — چه تعداد “r” — در کلمه “strawberry” وجود دارد.

چالشهای پیش روی هوش مصنوعی در پردازش زبان

این یک مشکل آسان برای حل نیست، زیرا در معماری اصلی که این مدلها را به کار میاندازد، نهادینه شده است.

این مسئله با یادگیری زبانهای بیشتر توسط یک مدل زبانی بزرگ پیچیدهتر میشود. به عنوان مثال، برخی از روشهای توکنیزاسیون ممکن است فرض کنند که یک فاصله در جمله همیشه یک کلمه جدید را پیشبینی میکند، اما بسیاری از زبانها مانند چینی، ژاپنی، تایلندی، لائوسی، کرهای و خمر از فضاها برای جدا کردن کلمات استفاده نمیکنند.

بهبود خوانایی و عملکرد هوش مصنوعی در پردازش تصویر

مدلهای تصویری مانند Midjourney و DALL-E از معماری ترانسفورمر استفاده نمیکنند. در عوض، آنها اغلب از مدلهای پخش استفاده میکنند که تصویری را از نویز بازسازی میکنند.

این مدلها روی پایگاههای داده بزرگ از تصاویر آموزش میبینند و تشویق میشوند تا چیزی شبیه به آنچه از دادههای آموزشی یاد گرفتهاند، ایجاد کنند.

نتیجهگیری

با تمام مشکلاتی که در مدلهای زبانی بزرگ وجود دارد، این مدلها همچنان در حال پیشرفت و بهبود هستند. با این حال، به نظر میرسد که مسیر طولانیای برای رسیدن به دقت و کارایی بیشتر در پیش دارند.

برای دریافت جدیدترین اخبار تکنولوژی و آموزشها لطفا عضو خبرنامه سامانه ایران شوید.

دیدگاهتان را بنویسید